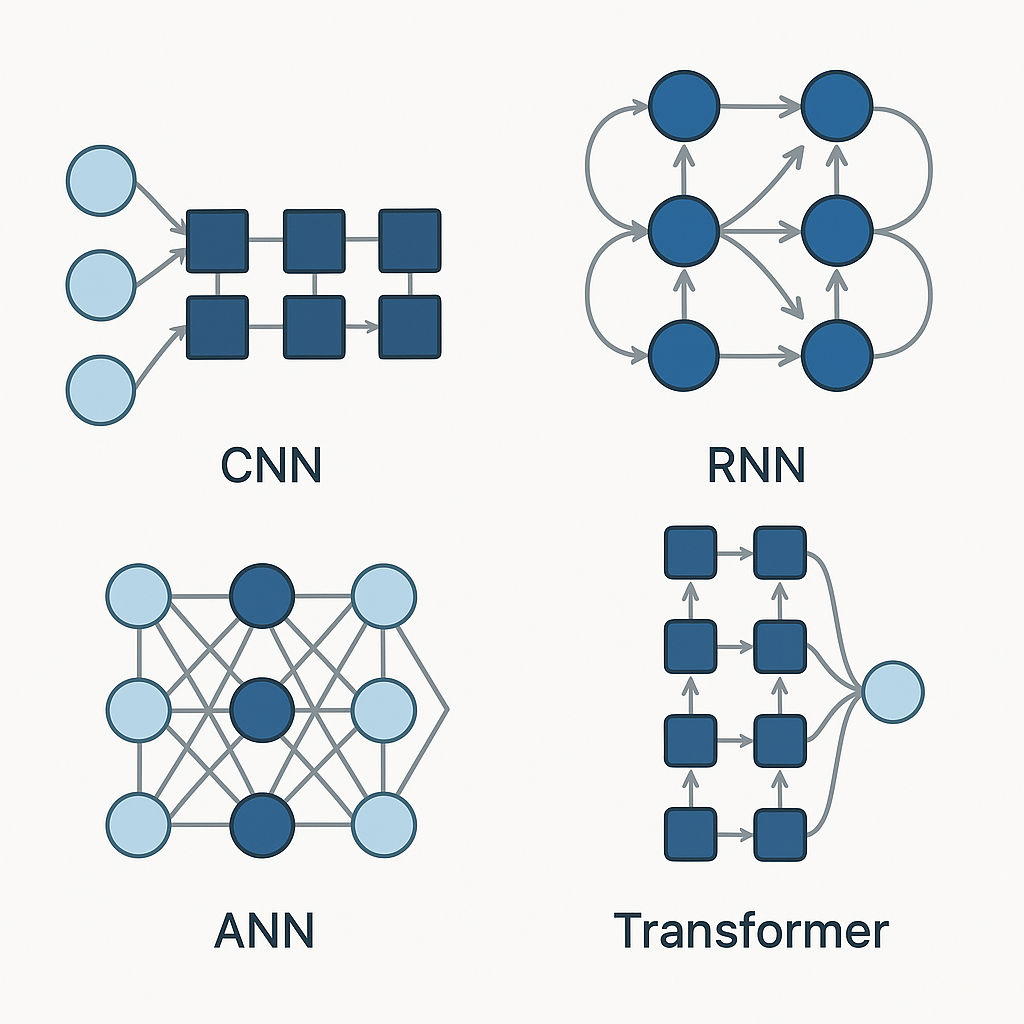

Redes Neurais Convolucionais (CNNs) e Redes Neurais Recorrentes (RNNs) são arquiteturas fundamentais em Deep Learning, cada uma otimizada para tipos diferentes de dados e tarefas.

Redes Neurais Convolucionais (CNN)

CNNs são projetadas para processar dados com estrutura espacial, como imagens. Elas usam operações de convolução para detectar padrões locais e hierárquicos.

Características Principais:

- Operações de convolução para extrair features

- Pooling para reduzir dimensionalidade

- Hierarquia de padrões (bordas → formas → objetos)

- Parâmetros compartilhados (eficiente)

Quando Usar CNNs:

- Classificação e detecção de imagens

- Reconhecimento facial

- Análise de imagens médicas

- Processamento de vídeo (frame por frame)

Redes Neurais Recorrentes (RNN)

RNNs são projetadas para processar sequências temporais, mantendo memória de informações anteriores. Elas têm conexões que formam ciclos, permitindo que a informação persista.

Características Principais:

- Memória de estados anteriores

- Processamento sequencial

- Capacidade de lidar com sequências de comprimento variável

- Variantes como LSTM e GRU para melhor memória de longo prazo

Quando Usar RNNs:

- Processamento de linguagem natural

- Tradução automática

- Análise de séries temporais

- Geração de texto e fala

Comparação Rápida

CNNs: Excelentes para dados espaciais, processamento paralelo eficiente, mas não lidam bem com sequências longas.

RNNs: Ideais para dados sequenciais, capturam dependências temporais, mas podem ser lentas e ter problemas com vanishing gradients.

Arquiteturas Híbridas

Em alguns casos, você pode combinar CNNs e RNNs:

- CNN para extrair features de imagens + RNN para processar sequências de features

- Video analysis: CNN processa frames, RNN processa sequência temporal

- Image captioning: CNN extrai features visuais, RNN gera descrições textuais

Alternativas Modernas

Hoje, arquiteturas mais modernas estão sendo preferidas:

- Transformers: Substituindo RNNs em muitas tarefas de NLP

- Vision Transformers: Alternativa aos CNNs para imagens

- Attention Mechanisms: Melhorando tanto CNNs quanto RNNs